리눅스 로컬 환경을 위한 한글 전문(Full-Text) 검색 데이터베이스 및 라이브러리 심층 분석

I. 서론: '로컬 한글 검색'의 기술적 과제 정의

1.1. 범위 정의: 로컬 검색 vs. 서버 검색

사용자 질의에서 명시된 '리눅스 로컬 검색'은 일반적인 클라이언트-서버(client-server) 아키텍처의 검색 엔진과는 근본적으로 다른 요구사항을 전제로 합니다. 로컬 검색은 Elasticsearch 1 또는 Apache Solr 2와 같이 별도의 서버 프로세스를 구동하고 네트워크를 통해 통신하는 방식이 아닙니다.

대신, 이는 다음과 같은 특성을 지닌 임베디드(embedded) 솔루션을 의미합니다.

라이브러리 형태: 애플리케이션의 프로세스 내에 라이브러리(.so,.jar,.py 등)로 직접 포함되어 실행됩니다.

제로-컨피그(Zero-Config): 별도의 서버 설정이나 관리 작업 없이 즉시 사용 가능해야 합니다.

저자원(Lightweight): 리눅스 데스크톱 애플리케이션 3, 임베디드 시스템 5, 또는 AI 에이전트 7와 같이 리소스가 제한적이거나 독립적인 환경에서 동작합니다.

따라서 본 보고서는 Meilisearch 8나 Elasticsearch와 같은 '검색 서버'가 아닌, 리눅스 환경에서 애플리케이션에 직접 내장할 수 있는 FTS(Full-Text Search) '라이브러리'에 초점을 맞춥니다. 분석 대상이 되는 핵심 후보군은 SQLite FTS5, Apache Lucene (임베디드 모드), Xapian, 그리고 Tantivy입니다.9

1.2. 핵심 난제: 왜 표준 검색이 한글에 실패하는가

로컬 검색 라이브러리를 선택하는 것보다 더 중요하고 본질적인 문제는 '한글' 검색의 정확성을 보장하는 것입니다. 표준 검색 기술이 한글과 같은 교착어(agglutinative language)를 만났을 때 실패하는 이유는 '토큰화(tokenization)' 방식의 근본적인 차이에 있습니다.

공백 토큰화의 오류: 영어 및 대부분의 유럽 언어는 공백(whitespace)을 기준으로 단어를 분리하는 '공백 토큰화' 방식이 유효합니다.13 예를 들어 "quick brown fox"는 "quick", "brown", "fox" 3개의 토큰으로 분리됩니다.

한글의 특성: 반면 한글은 공백으로 구분된 '어절(eojeol)' 내에 여러 개의 '형태소(morpheme)'가 결합되어 의미를 형성합니다.14 형태소는 의미를 가지는 최소 단위입니다.

실패 사례: 예를 들어, "서울대맛집"이라는 텍스트가 로컬 파일에 저장되어 있다고 가정해 보겠습니다.

공백 토크나이저(Whitespace Tokenizer)는 이 텍스트를 서울대맛집이라는 단일 토큰으로 인식합니다.15

이로 인해 사용자가 '서울' 혹은 '맛집'이라는 키워드로 검색을 시도하면, '서울'이라는 토큰이 인덱스에 존재하지 않으므로 검색 결과는 0건이 됩니다.

기본 FTS의 한계: 이 문제는 특정 도구에 국한되지 않습니다.

리눅스 기본 명령어인 grep은 단순 문자열 매칭이므로 '맛집'으로 검색할 수 있으나, 데이터가 1TB에 달할 경우 검색에 수 시간이 소요되어 로컬 검색 엔진으로서 실격입니다.18

SQLite FTS5의 기본 토크나이저인 unicode61은 유니코드 표준에 기반하지만, CJK(중국어, 일본어, 한국어) 언어의 형태소 분석을 지원하지 않아 한글 처리에 부적합합니다.19

대안으로 제시되는 trigram 토크나이저(텍스트를 3글자 단위로 쪼갬)는 '순매수'는 검색(3글자)할 수 있지만 '순매'(2글자)는 검색하지 못하는 등, 일관성 있는 한글 검색을 보장할 수 없습니다.22

Apache Lucene의 StandardAnalyzer 역시 CJK 언어 처리에 문제가 있어, 전용 분석기 없이는 동일한 한계에 부딪힙니다.23

1.3. 해결책: 형태소 분석기(Morphological Analyzer)의 필요성

이러한 문제를 해결하기 위한 유일한 방법은 단순한 문자열 분리가 아닌, 언어학적 구조를 이해하는 '형태소 분석기(Morphological Analyzer)'를 사용하는 것입니다.26

형태소 분석기는 "서울대맛집"이라는 어절을 입력받으면, 내부의 사전을 이용하여 '서울대(명사)'와 '맛집(명사)'이라는 두 개의 의미 있는 형태소로 분해(tokenizing)합니다. 이렇게 생성된 토큰('서울대', '맛집')을 인덱싱하면, 사용자는 '서울' 또는 '맛집'으로 정확한 검색 결과를 얻을 수 있습니다.

리눅스 환경에서 사용 가능한 주요 한글 형태소 분석기로는 MeCab 14, Nori (Lucene 내장) 29, Kiwipiepy (Python) 30, Okt (Open Korean Text) 31, Lindera (Rust) 32 등이 있습니다.

결론적으로, 사용자의 질의에 대한 답은 특정 '데이터베이스'의 이름이 될 수 없습니다. 성공적인 한글 검색은 **'FTS 엔진(데이터베이스 또는 라이브러리)'**과 **'한글 형태소 분석기(토크나이저)'**가 얼마나 안정적이고 효율적으로 통합되었느냐에 따라 결정됩니다. 본 보고서는 이 관점을 '제1원칙'으로 삼아, "최고의 한글 토크나이저를 가장 효율적으로 통합할 수 있는 FTS 라이브러리 스택"을 찾는 것을 목표로 각 솔루션을 심층 분석합니다.

II. 분석 프레임워크: 로컬 FTS 솔루션 스택 평가 기준

리눅스 로컬 환경에서 한글 전문 검색 스택을 평가하기 위해, 본 보고서는 다음과 같은 세 가지 핵심 기준을 적용하여 각 솔루션의 아키텍처와 트레이드오프를 분석합니다.

2.1. 한글 처리 품질 (정확성)

검색 엔진의 가장 기본적이면서 중요한 지표는 '검색 품질'입니다. 이는 FTS 엔진 자체가 아닌, 통합된 형태소 분석기의 성능에 의해 좌우됩니다.

형태소 분석 정확도: 사용된 분석기(예: MeCab-ko, Nori, Lindera-ko-dic)가 복합 명사와 동사 변형(conjugation)을 얼마나 정확하게 분리하고 원형을 복원(stemming/lemmatization)하는지 평가합니다.

신조어 및 미등록어 처리: 인덱싱되지 않은 신조어(예: '불멍')나 복합 명사(예: '서울대맛집')를 처리하는 능력입니다.14

사용자 사전(User Dictionary) 지원: 도메인 특화 용어(예: IT, 의료, 법률)나 고유 명사를 인덱싱하기 위해 사용자 정의 사전을 추가할 수 있는 기능은 상용 수준의 검색 품질에 필수적입니다.35

2.2. 성능 (효율성)

로컬 및 임베디드 환경은 서버 환경보다 리소스(CPU, RAM, Disk I/O)가 제한적이므로, 성능과 리소스 효율성이 매우 중요합니다.

인덱싱 속도 (Indexing Speed): 초기 대량의 로컬 파일이나 데이터를 인덱스로 구축하는 속도입니다. 이는 SQLite 37나 Xapian 38과 같이 C/C++ 기반 네이티브 라이브러리가 Python 기반 라이브러리보다 유리할 수 있습니다.

검색 지연 시간 (Query Latency): 사용자가 검색어를 입력했을 때 결과가 반환되기까지의 시간입니다. 실시간 로컬 검색 경험에 직결됩니다.38

리소스 사용량 (Resource Footprint): 인덱스가 차지하는 디스크 공간과, 검색 프로세스가 점유하는 메모리(RAM) 사용량입니다. 경량(lightweight) 솔루션을 찾는 사용자에게는 가장 중요한 요소일 수 있습니다.6

2.3. 구현 복잡성 및 생태계 (통합 용이성)

아무리 성능이 좋아도 개발자가 기존 리눅스 애플리케이션에 통합할 수 없다면 무용지물입니다.

주 사용 언어와의 통합: 개발자의 주력 언어(C, C++, Java, Python, Rust) 생태계 내에서 얼마나 원활하게 통합되는지 평가합니다.

의존성 관리: 한글 분석기 통합을 위해, SQLite처럼 소스 코드를 직접 컴파일하고 동적 라이브러리(*.so)를 수동 로드해야 하는지 39, 아니면 Lucene/Nori처럼 Maven/Gradle 의존성 선언만으로 해결되는지 41는 구현 난이도에 막대한 차이를 만듭니다.

커뮤니티 및 유지보수: 해당 솔루션 스택이 활발하게 유지보수되고 있는지, 관련 문서나 커뮤니티 지원이 풍부한지 여부입니다.

III. 솔루션 스택 1: SQLite FTS5 기반 접근 (C/C++ 생태계)

3.1. 개요: SQLite FTS5 아키텍처

SQLite는 리눅스를 포함한 거의 모든 운영체제에 기본적으로 탑재되어 있거나 쉽게 사용할 수 있는 사실상의 표준 임베디드 데이터베이스입니다.9 SQLite의 FTS5 확장 모듈은 CREATE VIRTUAL TABLE 구문을 통해 활성화되며, 별도 서버 없이 강력한 전문 검색 기능을 제공합니다.43

FTS5의 핵심 아키텍처적 특징은 '커스텀 토크나이저(Custom Tokenizer)' API입니다. 개발자는 C 언어로 sqlite3_tokenizer_module 인터페이스를 구현하여 자신만의 토크나이저를 만들 수 있습니다. 이 C 모듈을 동적 라이브러리(Linux에서는 .so 파일)로 컴파일한 뒤, SQLite 런타임에서 로드하여 FTS5 테이블에 연결할 수 있습니다.43 한글 검색은 바로 이 C 확장 모듈을 통해 구현되어야 합니다.

3.2. 대안 1: ICU (International Components for Unicode) 연동

ICU는 IBM에서 시작되어 현재 유니코드 컨소시엄이 관리하는 C/C++ 및 Java 라이브러리로, 강력한 유니코드 및 글로벌라이제이션 지원을 제공합니다.19 SQLite는 ICU 라이브러리를 통해 언어별 '단어 경계(word boundary)' 분석 기능을 FTS 토크나이저로 제공할 수 있습니다.

그러나 이 접근 방식에는 명확한 한계가 존재합니다.

품질의 한계: ICU의 기본 단어 경계 분석은 한글의 복합 명사나 용언 활용을 처리하는 전문 '형태소 분석' 수준이 아닙니다. MeCab이나 Nori와 같은 전문 분석기 대비 한글 검색 품질이 현저히 낮습니다.19

구현의 한계: SQLite는 ICU와 연동될 수 있지만, 대부분의 리눅스 배포판에 포함된 기본 SQLite 패키지는 ICU 옵션이 비활성화된 상태로 컴파일되어 있습니다.43

컴파일의 복잡성: ICU 토크나이저를 사용하려면, 개발자는 libicu-dev (Debian/Ubuntu) 또는 libicu-devel (Fedora) 패키지를 먼저 설치한 뒤 40, SQLite 소스 코드를 다운로드하여 ENABLE_ICU 컴파일 플래그를 명시적으로 활성화하고 SQLite 전체를 재컴파일해야 합니다.40

결론적으로 ICU 연동은 다국어 환경에서 최소한의 CJK 지원을 제공할 수는 있으나, 전문적인 한글 검색 솔루션으로 보기 어려우며 높은 구현 장벽이 존재합니다.

3.3. 대안 2: MeCab 연동 (fts5_mecab)

MeCab은 일본어용으로 개발되었으나 한글 사전(mecab-ko-dic)을 통해 널리 사용되는 고성능 C++ 기반 형태소 분석기입니다. fts5_mecab은 이 MeCab 엔진을 FTS5 토크나이저 API에 맞게 C 언어로 래핑(wrapping)한 서드파티 확장 모듈입니다.39

이 스택은 높은 품질의 한글 검색을 제공하지만, 그 대가로 극도로 복잡한 구현 과정을 요구합니다. fts5_mecab 프로젝트 39의 빌드 프로세스는 다음과 같습니다.

SQLite3 소스 컴파일: 시스템에 설치된 SQLite가 아닌, FTS5가 활성화된(--enable-fts5) SQLite 라이브러리를 소스 코드로부터 직접 컴파일하여 특정 경로(예: $HOME/usr)에 설치해야 합니다.

MeCab 소스 컴파일: MeCab 라이브러리 자체도 소스 코드에서 컴파일하여 동일한 경로에 설치해야 합니다.

MeCab 사전 소스 컴파일: 한글 사전(mecab-ipadic 또는 mecab-ko-dic) 역시 소스에서 컴파일하여 설치해야 합니다.

fts5_mecab 모듈 컴파일: 마지막으로, fts5_mecab.c 소스 파일을 gcc를 사용하여 컴파일합니다. 이때 1~3단계에서 수동으로 설치한 SQLite 및 MeCab 라이브러리의 헤더 파일과 라이브러리 경로를 -I 및 -L 플래그로 정확히 지정해야 합니다.

런타임 로드: 이렇게 생성된 fts5_mecab.so 파일을 SQLite 셸이나 애플리케이션 코드에서 .load /PATH/TO/fts5_mecab.so 명령을 통해 수동으로 로드한 뒤, CREATE VIRTUAL TABLE ft USING fts5(..., tokenize = 'mecab'); 구문으로 사용합니다.39

이 방식은 한글 처리 품질은 우수하지만, 의존성 관리가 매우 복잡하고 시스템 이식성을 심각하게 저해합니다. C/C++ 네이티브 개발 환경에 매우 익숙하고, 배포 파이프라인을 완벽하게 제어할 수 있는 경우가 아니라면 권장하기 어렵습니다.

3.4. 대안 3: Lindera 연동 (lindera-sqlite)

Lindera는 Rust로 작성된 현대적인 형태소 분석기 라이브러리로, MeCab의 대안으로 부상하고 있습니다.32 lindera-sqlite 48는 Lindera를 SQLite FTS5 토크나이저로 사용할 수 있도록 C-ABI(C Application Binary Interface) 호환 라이브러리로 노출하는 프로젝트입니다.

구현 방식은 fts5_mecab과 유사한 절차를 따릅니다.48

Rust 빌드: Rust의 빌드 도구인 cargo를 사용하여 cargo build --features=embedded-cjk 명령으로 liblindera_sqlite 동적 라이브러리를 빌드합니다.

환경 변수 설정: Lindera 설정 파일(*.yml)의 경로를 LINDERA_CONFIG_PATH 환경 변수로 지정해야 합니다.

런타임 로드: SQLite에서 .load./target/debug/liblindera_sqlite lindera_fts5_tokenizer_init 명령으로 모듈을 로드하고 tokenize='lindera_tokenizer' 구문으로 사용합니다.48

MeCab 스택에 비해 C++ 대신 Rust라는 최신 기술 스택을 사용하지만, 여전히 C 동적 라이브러리를 수동으로 빌드하고 로드해야 하는 근본적인 복잡성은 동일하게 공유합니다.

SQLite FTS5 스택은 경량 임베디드 DB라는 강력한 이점에도 불구하고 7, 한글 검색 품질을 확보하기 위한 '플러그인' 방식 45이 높은 기술적 부채를 발생시킵니다. 즉, 이식성 (기본 SQLite)과 한글 검색 품질 (커스텀 컴파일 SQLite) 사이의 고통스러운 트레이드오프가 존재합니다.

IV. 솔루션 스택 2: Apache Lucene 임베디드 모드 (Java 생태계)

4.1. 개요: 라이브러리로서의 Lucene

Apache Lucene은 Elasticsearch와 Solr의 핵심 검색 엔진으로 널리 알려져 있지만 1, 그 본질은 고성능 FTS '라이브러리'입니다. Lucene은 Java로 작성되었으며, 서버가 아닌 lucene-core.jar 파일 형태로 애플리케이션에 직접 임베드되어 로컬 인덱싱 및 검색 기능을 완벽하게 수행할 수 있습니다.49

Lucene 아키텍처의 유연성은 Analyzer 클래스에서 나옵니다.51 Analyzer는 텍스트를 토큰 스트림으로 변환하는 Tokenizer와, 이 토큰들을 가공(소문자 변환, 불용어 제거, 원형 복원 등)하는 0개 이상의 TokenFilter로 구성된 파이프라인입니다.53 한글 검색은 이 Analyzer 구현체를 한글 전용 분석기로 교체함으로써 달성됩니다.

4.2. 핵심 솔루션: Nori (노리) 한글 형태소 분석기

SQLite 스택이 한글 처리를 위해 복잡한 서드파티 모듈 컴파일을 요구했던 것과 달리, Lucene 스택은 'Nori(노리)'라는 공식 한글 분석기를 제공합니다.

공식 모듈: Nori (lucene-analysis-nori)는 Apache Lucene 프로젝트에서 직접 개발하고 배포하는 공식 하위 모듈입니다.29 이는 Lucene의 릴리스 사이클과 호환성을 완벽하게 보장받는다는 의미입니다.

높은 품질: Nori는 mecab-ko-dic 한글 사전을 기반으로 구축되어(현재는 Lucene이 자체 포맷으로 관리) 55, MeCab 수준의 높은 형태소 분석 품질을 제공합니다.

강력한 기능: 단순한 토큰 분리를 넘어, 복합 명사 분해(DecompoundMode), 품사(POS) 태깅, 불용어 처리, 사용자 사전 추가 35 등 고급 한글 처리에 필요한 모든 기능을 내장하고 있습니다.29

4.3. 구현: Java 애플리케이션에 Nori 통합하기

Lucene과 Nori 스택의 가장 큰 장점은 압도적인 '구현 편의성'입니다. SQLite/MeCab 스택의 복잡한 C 컴파일 과정 39과 비교할 때, Java 생태계에서는 이 모든 과정이 몇 줄의 설정으로 끝납니다.

- 의존성 추가 (Maven/Gradle)

pom.xml (Maven) 또는 build.gradle (Gradle) 58 파일에 다음과 같이 의존성 두 줄만 추가하면 됩니다.

XML

org.apache.lucene

lucene-core

9.9.1

org.apache.lucene

lucene-analysis-nori

9.9.1

이 선언만으로 lucene-core 라이브러리와 nori 한글 분석기 및 관련 사전 파일이 자동으로 다운로드되고 클래스패스에 설정됩니다.

2. Java 코드 예제

Nori를 사용하는 것은 다른 Lucene Analyzer를 사용하는 것과 완벽하게 동일합니다.

Java

// [35, 51, 57, 58, 59, 60, 76]

import org.apache.lucene.analysis.Analyzer;

import org.apache.lucene.analysis.ko.KoreanAnalyzer;

import org.apache.lucene.analysis.ko.KoreanTokenizer;

import org.apache.lucene.analysis.ko.KoreanPartOfSpeechStopFilter;

import org.apache.lucene.document.;

import org.apache.lucene.index.;

import org.apache.lucene.store.;

import org.apache.lucene.search.;

import org.apache.lucene.queryparser.classic.QueryParser;

import java.nio.file.Paths;

import java.util.Collections;

public class LuceneNoriExample {

public static void main(String args) throws Exception {

// 1. Nori 분석기 생성 [35, 57, 60]

// 사용자 사전, 복합명사 분해 모드, 불용어 태그 등 세부 설정 가능

Analyzer noriAnalyzer = new KoreanAnalyzer(

null, // UserDictionary (사용자 사전 경로, null일 경우 기본 사전)

KoreanTokenizer.DecompoundMode.DISCARD, // 복합명사 분해 모드 (DISCARD: 원본 유지 안 함)

KoreanPartOfSpeechStopFilter.DEFAULT_STOP_TAGS, // 기본 불용어 품사 (조사, 어미 등)

false // outputUnknownUnigrams (미등록어 유니그램 출력 여부)

);

// 2. 로컬 파일 시스템 디렉토리(FSDirectory)에 인덱스 설정 [59]

// [50]

Directory indexDir = FSDirectory.open(Paths.get("/opt/linux-local-search/index"));

IndexWriterConfig config = new IndexWriterConfig(noriAnalyzer);

IndexWriter writer = new IndexWriter(indexDir, config);

// 3. 문서 추가: "서울대학교 맛집" 인덱싱 [76]

Document doc = new Document();

doc.add(new TextField("content", "서울대학교 맛집 정보입니다.", Field.Store.YES));

doc.add(new StringField("filename", "doc1.txt", Field.Store.YES));

writer.addDocument(doc);

writer.close(); // 커밋 및 인덱스 쓰기 완료

// 4. 검색: Nori 분석기를 사용하여 "서울 맛집" 검색 [76]

IndexReader reader = DirectoryReader.open(indexDir);

IndexSearcher searcher = new IndexSearcher(reader);

// 중요: 검색 시에도 인덱싱과 동일한 Analyzer를 사용해야 함

QueryParser parser = new QueryParser("content", noriAnalyzer);

Query query = parser.parse("서울 맛집"); // "서울", "맛집"으로 토큰화됨

TopDocs docs = searcher.search(query, 10);

System.out.println("'" + "서울 맛집" + "' 검색 결과 (" + docs.totalHits.value + "건):");

for (ScoreDoc scoreDoc : docs.scoreDocs) {

Document hitDoc = searcher.doc(scoreDoc.doc);

System.out.println("- " + hitDoc.get("filename") + ": " + hitDoc.get("content"));

}

reader.close();

indexDir.close();

}

}

이처럼 Java 생태계 내에서는 new KoreanAnalyzer() 60 단 한 줄의 코드로 모든 복잡성이 해결됩니다. 이는 SQLite 스택이 요구하는 C 컴파일, 라이브러리 패스 설정, .load 명령어 등의 시스템 레벨 작업 39과 극명한 대비를 이룹니다.

만약 개발 중인 리눅스 로컬 애플리케이션이 이미 Java(JVM) 기반(예: Android, JavaFX 데스크톱 앱, IntelliJ 플러그인 등)이라면, '임베디드 Lucene + Nori' 스택은 한글 검색을 위한 가장 강력하고 편리하며 성숙한 솔루션입니다. 유일한 트레이드오프는 C/C++ 네이티브 라이브러리 대비 JVM이 차지하는 고정 메모리 사용량입니다.

V. 솔루션 스택 3: 현대적 대안 (Rust 및 Python 생태계)

C/C++와 Java 생태계 외에도, 리눅스 로컬 검색을 위한 현대적인 FTS 라이브러리들이 Rust와 Python 생태계에 존재합니다. 이들은 각 언어의 특성에 맞는 한글 검색 통합 방식을 제공합니다.

5.1. Rust: Tantivy + Lindera

Tantivy는 Apache Lucene에 영감을 받아 100% Rust로 작성된 FTS 라이브러리입니다.12 Rust의 메모리 안전성과 'zero-cost abstraction' 철학을 바탕으로 개발되어, Lucene을 능가하는 검색 성능을 보여주는 벤치마크 결과도 존재합니다.33

Tantivy의 가장 큰 장점 중 하나는 매우 짧은 시작 시간(<10ms)으로 33, 리눅스 환경의 경량 CLI(Command-Line Interface) 도구나 에이전트에 내장하기에 이상적입니다.

한글 통합:

Tantivy 자체에는 Lucene의 Nori와 같은 공식 한글 토크나이저가 내장되어 있지 않습니다. 하지만 Lucene과 마찬가지로 유연한 Tokenizer 트레잇(trait)을 제공하여 65, 서드파티 토크나이저를 쉽게 통합할 수 있습니다.

한글 검색을 위해서는 Rust 기반 형태소 분석기인 Lindera와 lindera-ko-dic-builder (한글 사전 빌더)를 함께 사용합니다.33 lindera-tantivy 33라는 전용 크레이트(crate, Rust 라이브러리)가 이 통합을 지원합니다.

평가:

Tantivy + Lindera 스택은 '최고 수준의 성능'과 '낮은 리소스 사용량'을 동시에 달성할 수 있는 가장 현대적인 솔루션입니다. Java의 Nori만큼 통합이 간편하지는 않지만, SQLite의 C 모듈 컴파일 지옥 39과 비교하면 Rust의 패키지 매니저 cargo를 통한 의존성 관리가 훨씬 안정적이고 현대적입니다. 성능이 극도로 중요한 리눅스 시스템 유틸리티나 신규 프로젝트 개발 시 가장 우선적으로 고려해야 할 차세대 아키텍처입니다.

5.2. Python: Whoosh + Kiwip/Okt

Whoosh는 100% 순수 Python으로 작성된 FTS 라이브러리입니다.61 Java의 Lucene이나 Rust의 Tantivy와 달리, C 확장이나 외부 라이브러리 의존성 없이 pip install Whoosh만으로 설치하여 사용할 수 있습니다.

한글 통합:

Whoosh의 가장 큰 장점은 Python의 유연성을 그대로 활용한다는 점입니다. Analyzer API는 개발자가 쉽게 커스터마이징할 수 있는 Python 클래스로 구성됩니다.69

한글 검색을 위해서는 pip으로 설치 가능한 Python 기반 형태소 분석기(예: Kiwipiepy 30, Okt 31)를 Whoosh의 Tokenizer 클래스와 연동하면 됩니다.70

Python

[30, 70, 71]

from whoosh.analysis import Tokenizer, Token

from whoosh.fields import Schema, TEXT

from whoosh.index import create_in

from kiwipiepy import Kiwi #

1. Kiwipiepy를 사용하는 커스텀 토크나이저 정의

class KiwiTokenizer(Tokenizer):

def init(self):

self.kiwi = Kiwi()

def __call__(self, text_string, **kwargs):

# Kiwipiepy로 형태소 분석 [14, 26]

tokens = self.kiwi.tokenize(text_string)

token = Token() # Whoosh 토큰 객체

for t in tokens:

token.text = t.form # 토큰 텍스트

token.pos = t.start # 시작 위치 (인덱스)

token.charpos = t.start # 문자열 내 위치

token.endchar = t.end

yield token

2. 커스텀 Analyzer 생성 [69, 71]

(필요에 따라 LowercaseFilter, StopFilter 등을 | 파이프로 추가 가능)

korean_analyzer = KiwiTokenizer()

3. 스키마 정의 및 인덱스 생성

schema = Schema(content=TEXT(analyzer=korean_analyzer, stored=True))

#... 인덱스 생성 및 문서 추가...

평가 및 성능 한계:

Whoosh 스택은 Python 개발자에게 최고의 '개발 편의성'과 '신속한 프로토타이핑' 환경을 제공합니다. 하지만 순수 Python으로 구현된 만큼 67, C++(Xapian), Java(Lucene), Rust(Tantivy)로 작성된 네이티브 라이브러리에 비해 인덱싱 및 검색 속도가 현저히 느립니다.38 수십 GB 이상의 대용량 로컬 파일을 다루거나 실시간 고성능 검색이 필요한 환경에는 적합하지 않을 수 있습니다.

5.3. (비교) Xapian (C++)

Xapian은 "SQLite의 검색 버전"이라 불릴 만큼 가볍고(lightweight) 빠른 C++ FTS 라이브러리입니다.6 성능 면에서는 순수 Python인 Whoosh를 압도합니다.38

하지만 Xapian 역시 Lucene(Nori)이나 Tantivy(Lindera)처럼 잘 통합된 공식 한글 토크나이저 생태계가 부족합니다.74 결국 SQLite FTS5 스택과 마찬가지로, 개발자가 직접 C++ MeCab 14을 수동으로 연동해야 하는(bridging) 높은 구현 허들에 직면하게 됩니다.75

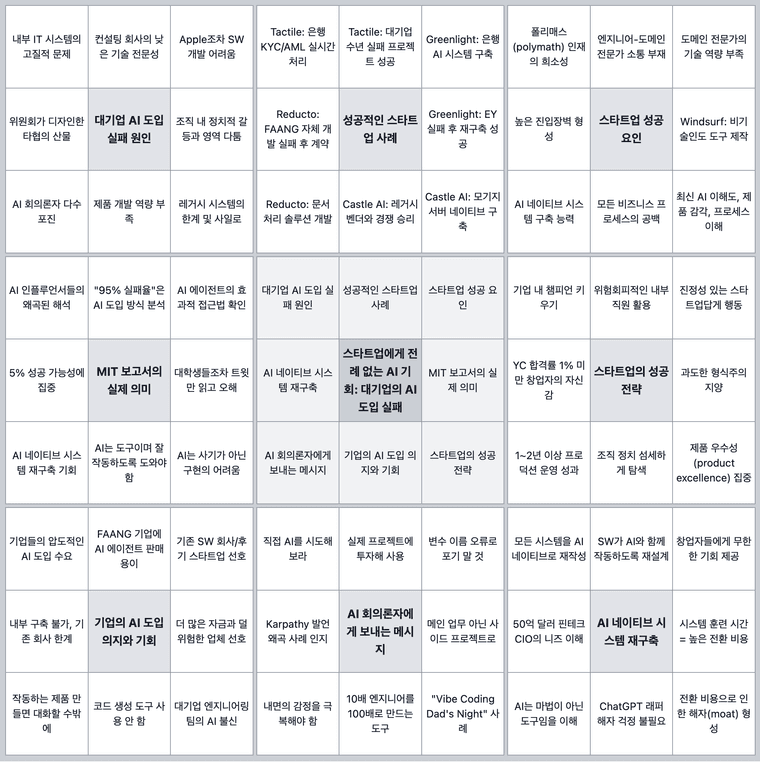

VI. 종합 비교 분석 및 핵심 권장 사항

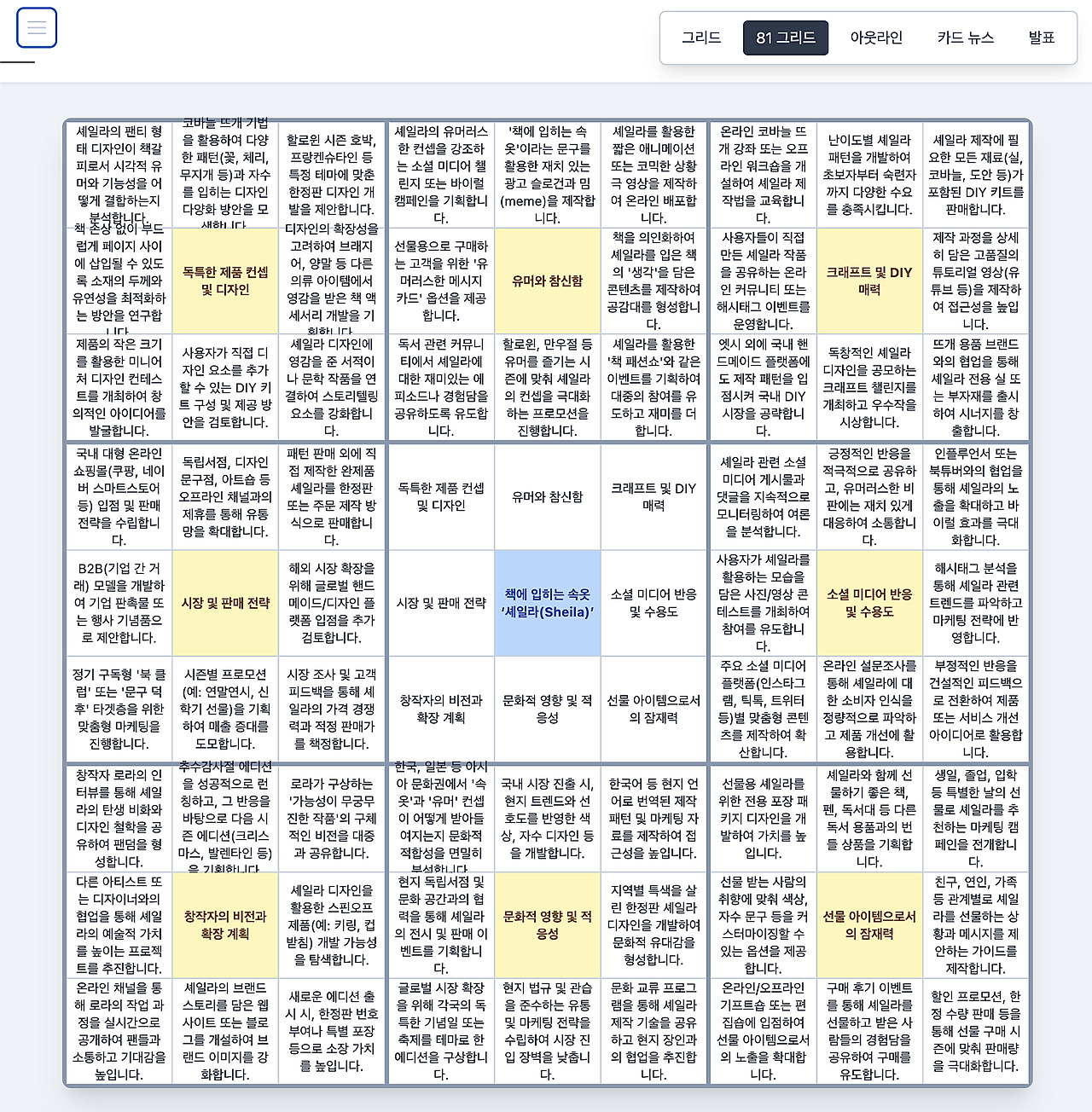

6.1. 핵심 비교 테이블: 로컬 한글 검색 솔루션 스택

지금까지 분석한 4가지 주요 스택의 특성을 요약하면 다음과 같습니다. 각 솔루션은 단순한 라이브러리가 아닌, 'FTS 엔진 + 한글 토크나이저'가 결합된 '스택'으로 비교해야 그 장단점을 명확히 파악할 수 있습니다.

테이블: 로컬 한글 검색 솔루션 스택 비교

평가 항목

SQLite + MeCab/Lindera

Embedded Lucene + Nori

Tantivy + Lindera

Whoosh + Kiwip/Okt

주 사용 언어

C, C++

Java (JVM)

Rust

Python

한글 처리 품질

높음 (MeCab/Lindera 성능)

매우 높음 (Nori: 공식, 성숙) 29

높음 (Lindera 성능)

중간~높음 (Python 분석기 의존)

한글 설정 난이도

매우 높음 (C 소스 컴파일,.so 로드) 39

매우 낮음 (Maven/Gradle 의존성 추가) 41

중간 (Cargo 의존성 관리) 33

낮음 (pip install 및 Python 코드) 70

인덱싱 성능

중간 (C 네이티브) 37

높음

매우 높음 33

낮음 38

검색 성능

높음

매우 높음

매우 높음 33

낮음 72

메모리 점유율

매우 낮음 7

높음 (JVM 오버헤드)

매우 낮음 33

중간 (Python 오버헤드)

생태계 성숙도

높음 (SQLite) / 낮음 (Tokenizer)

매우 높음 1

중간 (빠르게 성장 중)

중간 68

핵심 자료

39

29

33

30

6.2. 시나리오별 최종 권장 사항

위의 비교 분석을 바탕으로, 사용자의 리눅스 로컬 환경과 개발 스택에 따른 최적의 솔루션을 다음과 같이 권장합니다.

시나리오 1: C/C++ 기반 기존 리눅스 데스크톱/임베디드 애플리케이션에 통합 시

권장: SQLite FTS5 + Lindera 48 또는 MeCab 39

이유: C/C++ 네이티브 환경에서는 JVM(Java)이나 Python 인터프리터를 새로 추가하는 것 자체가 막대한 오버헤드입니다. SQLite는 이미 시스템에 존재할 가능성이 높으며 42, C로 컴파일된 .so 동적 라이브러리를 로드하는 것이 아키텍처상 가장 자연스럽습니다. 성능과 저자원 측면에서 가장 유리하며 11, 그 대가로 39/48에서 확인된 복잡한 빌드 파이프라인을 감수해야 합니다.

시나리오 2: Java 기반 로컬 애플리케이션(예: IntelliJ 플러그인, JavaFX 데스크톱 앱) 개발 시

권장: Embedded Lucene + Nori 29

이유: 다른 대안을 고민할 필요가 없는 최적의 선택입니다. 41에서 보듯 Maven/Gradle 의존성 추가만으로 가장 성숙하고 강력한 '공식' 한글 분석기(Nori)를 즉시 사용할 수 있습니다. 57의 예제처럼 통합이 매우 간단하며, 리눅스 환경에서도 완벽하게 동일하게 작동합니다.

시나리오 3: 성능이 극도로 중요하고, 리소스가 제한된 신규 리눅스 프로젝트 개발 시

권장: Tantivy + Lindera 33

이유: Lucene보다 빠르거나 동등한 최고 수준의 성능을 제공하면서 33, JVM 오버헤드가 전혀 없습니다. SQLite+C 모듈 스택의 컴파일 복잡성을 39 Rust의 현대적인 패키지 매니저 cargo로 해결합니다.33 리눅스 시스템 유틸리티, 고성능 에이전트 7 등에 가장 적합한 '차세대' 솔루션입니다.

시나리오 4: Python 환경에서 빠른 프로토타이핑 또는 관리 도구 개발 시

권장: Whoosh + Kiwipiepy 30

이유: Python 개발 환경을 벗어날 필요 없이 pip 설치와 순수 Python 코드만으로 모든 것을 해결할 수 있어 '개발 속도'가 가장 빠릅니다.70 단, 38에서 지적되듯, 성능이 중요한 대규모 데이터 인덱싱에는 적합하지 않음을 명확히 인지해야 합니다.

VII. 결론: '데이터베이스'가 아닌 '언어 처리 스택'의 선택

본 보고서는 "리눅스 로컬 한글 검색"이라는 질의가 단순한 '데이터베이스' 선택의 문제가 아님을 명확히 밝혔습니다. 이는 '핵심 FTS 엔진'과 '한글 형태소 분석기'의 결합으로 이루어진 '기술 스택'을 선택하는 아키텍처 결정의 문제입니다.

한글 검색의 성공 여부와 품질은 SQLite나 Lucene의 코어 성능이 아닌, Nori29, MeCab39, Lindera48와 같은 형태소 분석기의 언어학적 품질과, FTS 엔진과의 통합 용이성에 의해 결정됩니다.

따라서 최종 결정은 귀하의 프로젝트가 사용 중인 주력 언어 생태계(C/C++, Java, Rust, Python)에 따라 달라집니다.

Java 생태계는 'Lucene + Nori'라는 가장 성숙하고 편리한 '공식' 솔루션을 보유하고 있습니다.

C/C++ 생태계는 'SQLite + MeCab/Lindera'를 통해 가장 낮은 리소스 사용량을 달성할 수 있으나, 매우 복잡한 커스텀 컴파일 및 배포 과정을 요구합니다.

Rust 생태계는 'Tantivy + Lindera'라는 가장 빠르고 현대적인 대안을 제시하며, C/C++의 복잡성을 해결하는 유망한 미래로 부상하고 있습니다.

Python 생태계는 'Whoosh'를 통해 가장 빠른 개발 속도를 제공하지만, 성능상의 명확한 한계를 가집니다.

귀하의 리눅스 로컬 환경과 애플리케이션의 주력 개발 스택을 면밀히 검토하여, 본 보고서 6.2절에서 제시한 4가지 시나리오 중 가장 적합한 아키텍처를 선택하시길 권장합니다.

참고 자료

ElasticSearch, Sphinx, Lucene, Solr, Xapian. Which fits for which usage? - Stack Overflow, 11월 7, 2025에 액세스, https://stackoverflow.com/questions/2271600/elasticsearch-sphinx-lucene-solr-xapian-which-fits-for-which-usage

7 Open-Source Search Engines for your Enterprise and Startups you MUST know., 11월 7, 2025에 액세스, https://dev.to/swirl/7-open-source-search-engines-for-your-enterprise-and-startups-you-must-know-4504

DocFetcher – Fast Document Search, 11월 7, 2025에 액세스, https://docfetcher.sourceforge.io/

Linux Desktop Search Engines Compared, 11월 7, 2025에 액세스, https://www.linux.com/news/linux-desktop-search-engines-compared/

A curated list of awesome Embedded Linux resources. - GitHub, 11월 7, 2025에 액세스, https://github.com/fkromer/awesome-embedded-linux

Lightweight Search Indexing API/Lbrary - Stack Overflow, 11월 7, 2025에 액세스, https://stackoverflow.com/questions/90584/lightweight-search-indexing-api-lbrary

Turso - Databases Everywhere, 11월 7, 2025에 액세스, https://turso.tech/

Improving Meilisearch's language support, 11월 7, 2025에 액세스, https://www.meilisearch.com/blog/improving-meilisearchs-language-support

Top 8 Embedded SQL Databases in 2025 - Explo, 11월 7, 2025에 액세스, https://www.explo.co/blog/embedded-sql-databases

6 Best Embedded Databases for 2024 - Ghost, 11월 7, 2025에 액세스, https://latitude-blog.ghost.io/blog/6-best-embedded-databases-2024/

Matchups: Lucene vs Xapian | Search Technologies Comparison, 11월 7, 2025에 액세스, https://www.swiftorial.com/matchups/search_technologies/lucene-vs-xapian

tantivy - Rust | Titan AI Explore, 11월 7, 2025에 액세스, https://www.titanaiexplore.com/projects/tantivy-49412556

Whitespace tokenizer | Reference - Elastic, 11월 7, 2025에 액세스, https://www.elastic.co/docs/reference/text-analysis/analysis-whitespace-tokenizer

Korean Tokenization & Lemmatization | by Vitalii Koren - Medium, 11월 7, 2025에 액세스, https://korenv20.medium.com/korean-tokenization-lemmatization-a741fc9939cc

[AIS] When Japanese/Chinese/Korean users use whitespaces in the search term, the Search Tokenization does not take the whitespace into account, and so it does not return the document with the same characters in the Search Results - ServiceNow support, 11월 7, 2025에 액세스, https://support.servicenow.com/kb?id=kb_article_view&sysparm_article=KB1220272

Can't get CJKAnalyzer/Tokenizer to recognise japanese text - Stack Overflow, 11월 7, 2025에 액세스, https://stackoverflow.com/questions/8753177/cant-get-cjkanalyzer-tokenizer-to-recognise-japanese-text

Korean tokenizer does not work · Issue #490 · stanfordnlp/stanza - GitHub, 11월 7, 2025에 액세스, https://github.com/stanfordnlp/stanza/issues/490

How to speed up a search on large collection of text files (1TB) - Stack Overflow, 11월 7, 2025에 액세스, https://stackoverflow.com/questions/62095687/how-to-speed-up-a-search-on-large-collection-of-text-files-1tb

Introducing: FTS5 ICU Tokenizer for Better Multilingual Text Search : r/sqlite - Reddit, 11월 7, 2025에 액세스, https://www.reddit.com/r/sqlite/comments/1nkaqiq/introducing_fts5_icu_tokenizer_for_better/

Unicode support for non-English characters with Sqlite Full Text Search in Android, 11월 7, 2025에 액세스, https://stackoverflow.com/questions/29669342/unicode-support-for-non-english-characters-with-sqlite-full-text-search-in-andro

Why sqlite fts5 Unicode61 Tokenizer does not support CJK(Chinese Japanese Korean)?, 11월 7, 2025에 액세스, https://stackoverflow.com/questions/52422437/why-sqlite-fts5-unicode61-tokenizer-does-not-support-cjkchinese-japanese-korean

[Bug]: Querying with certain foreign language data is failing to return correctly with sqlite3 fts5 tokenizer='trigram' #1073 - GitHub, 11월 7, 2025에 액세스, https://github.com/chroma-core/chroma/issues/1073

Lucene 3.5 is not supporting Chinese Russain Korean Languages while searching, 11월 7, 2025에 액세스, https://stackoverflow.com/questions/48055694/lucene-3-5-is-not-supporting-chinese-russain-korean-languages-while-searching

Best cross-language analyzer to use with lucene index [closed] - Stack Overflow, 11월 7, 2025에 액세스, https://stackoverflow.com/questions/1001003/best-cross-language-analyzer-to-use-with-lucene-index

Which Lucene Analyzer should be used Korean language analysis? - Stack Overflow, 11월 7, 2025에 액세스, https://stackoverflow.com/questions/28567911/which-lucene-analyzer-should-be-used-korean-language-analysis

A Visualization Tool for Korean Morphological Analyzer - Department of Computer Science and Engineering - HKUST, 11월 7, 2025에 액세스, https://cse.hkust.edu.hk/acl2000/Demo/18_choi.pdf

Building a Korean morphological analyzer using two Korean BERT models - PMC - NIH, 11월 7, 2025에 액세스, https://pmc.ncbi.nlm.nih.gov/articles/PMC9137944/

An Empirical Study of Korean Sentence Representation with Various Tokenizations - MDPI, 11월 7, 2025에 액세스, https://www.mdpi.com/2079-9292/10/7/845

Lucene 8.11.0 analyzers-nori API, 11월 7, 2025에 액세스, https://lucene.apache.org/core/7_4_0/analyzers-nori/index.html

kiwipiepy - PyPI, 11월 7, 2025에 액세스, https://pypi.org/project/kiwipiepy/

Experimental Study of Morphological Analyzers for Topic Categorization in News Articles, 11월 7, 2025에 액세스, https://www.mdpi.com/2076-3417/13/19/10572

Script based tokenizer - the Meilisearch specifications!, 11월 7, 2025에 액세스, https://specs.meilisearch.dev/specifications/text/0001-script-based-tokenizer.html

Tantivy is a full-text search engine library inspired by Apache Lucene and written in Rust - GitHub, 11월 7, 2025에 액세스, https://github.com/quickwit-oss/tantivy

Can I turn off Korean tokenizer? · meilisearch · Discussion #683 - GitHub, 11월 7, 2025에 액세스, https://github.com/orgs/meilisearch/discussions/683

KoreanAnalyzer (Lucene 7.4.0 API), 11월 7, 2025에 액세스, https://lucene.apache.org/core/7_4_0/analyzers-nori/org/apache/lucene/analysis/ko/KoreanAnalyzer.html

[Nori] Add metadata support for Korean analyzer tokens · Issue #14940 · apache/lucene, 11월 7, 2025에 액세스, https://github.com/apache/lucene/issues/14940

Performance Analysis - SQLite User Forum, 11월 7, 2025에 액세스, https://sqlite.org/forum/info/47429810bd2232ebe0c1096c4910b43f6313b9d92bca6eab8496d59d3f585e4c

Simon Willison on full-text-search, 11월 7, 2025에 액세스, https://simonwillison.net/tags/full-text-search/

thino-rma/fts5_mecab: sqlite3 fts5 mecab - GitHub, 11월 7, 2025에 액세스, https://github.com/thino-rma/fts5_mecab

Compiling SQLite3 with the ICU tokenizer - Zhiming Wang, 11월 7, 2025에 액세스, https://blog.zhimingwang.org/compiling-sqlite3-with-icu-tokenizer

org.apache.lucene:lucene-analyzers-nori - Maven Central - Sonatype, 11월 7, 2025에 액세스, https://central.sonatype.com/artifact/org.apache.lucene/lucene-analyzers-nori

What are the best databases for Embedded Linux OS - Reddit, 11월 7, 2025에 액세스, https://www.reddit.com/r/Database/comments/n8e5iu/what_are_the_best_databases_for_embedded_linux_os/

SQLite FTS5 Extension, 11월 7, 2025에 액세스, https://sqlite.org/fts5.html

Full-Text Search in SQLite: A Practical Guide | by Johni Douglas Marangon | Medium, 11월 7, 2025에 액세스, https://medium.com/@johnidouglasmarangon/full-text-search-in-sqlite-a-practical-guide-80a69c3f42a4

SQLite FTS5 Extension - Hacker News, 11월 7, 2025에 액세스, https://news.ycombinator.com/item?id=41198422

FTS5 ICU Tokenizer for SQLite - GitHub, 11월 7, 2025에 액세스, https://github.com/cwt/fts5-icu-tokenizer

Japanese Full-Text Search in SQLite - elianiva, 11월 7, 2025에 액세스, https://elianiva.my.id/posts/japanese-fts-using-sqlite/

lindera/lindera-sqlite: Lindera for SQLite FTS5 extention - GitHub, 11월 7, 2025에 액세스, https://github.com/lindera/lindera-sqlite

Integrating search in your application with Apache Lucene | by Dhruvsharma - Medium, 11월 7, 2025에 액세스, https://medium.com/@dhruvsharma2600/integrating-search-in-your-application-with-apache-lucene-d11c6fb84ab4

Lucene In-Memory Text Search Example - JavaTechniques, 11월 7, 2025에 액세스, https://javatechniques.com/blog/lucene-in-memory-text-search-example/

Guide to Lucene Analyzers | Baeldung, 11월 7, 2025에 액세스, https://www.baeldung.com/lucene-analyzers

Lucene Tutorial, 11월 7, 2025에 액세스, http://web.cs.ucla.edu/classes/winter15/cs144/projects/lucene/index.html

Lucene Linguistics - Vespa Documentation, 11월 7, 2025에 액세스, https://docs.vespa.ai/en/lucene-linguistics.html

Apache Lucene Migration Guide, 11월 7, 2025에 액세스, https://lucene.apache.org/core/9_0_0/MIGRATE.html

Korean (nori) analysis plugin | Reference - Elastic, 11월 7, 2025에 액세스, https://www.elastic.co/docs/reference/elasticsearch/plugins/analysis-nori

Nori, a Korean analyzer based on mecab-ko-dic [LUCENE-8231] #9278 - GitHub, 11월 7, 2025에 액세스, https://github.com/apache/lucene/issues/9278

lucene/analysis/nori/src/java/org/apache/lucene/analysis/ko/KoreanAnalyzer.java - lucene - Git at Google, 11월 7, 2025에 액세스, https://apache.googlesource.com/lucene/+/refs/heads/revamp_geopath/lucene/analysis/nori/src/java/org/apache/lucene/analysis/ko/KoreanAnalyzer.java

nocode2k/nori-analyzer-example: nori analysis java application example - GitHub, 11월 7, 2025에 액세스, https://github.com/nocode2k/nori-analyzer-example

A Simple File Search with Lucene | Baeldung, 11월 7, 2025에 액세스, https://www.baeldung.com/lucene-file-search

KoreanAnalyzer (Lucene 9.3.0 nori API), 11월 7, 2025에 액세스, https://lucene.apache.org/core/9_3_0/analysis/nori/org/apache/lucene/analysis/ko/KoreanAnalyzer.html

Comparison of open source search engines - Abilian Innovation Lab, 11월 7, 2025에 액세스, https://lab.abilian.com/Tech/Search/Comparison of open source search engines/

Up and coming Tantivy 0.7 is faster than Lucene in most tests : r/rust - Reddit, 11월 7, 2025에 액세스, https://www.reddit.com/r/rust/comments/962n86/up_and_coming_tantivy_07_is_faster_than_lucene_in/

tantivy 0.22 has been released! Performance and Stability Improvements, Top Hits and Term Aggregations : r/rust - Reddit, 11월 7, 2025에 액세스, https://www.reddit.com/r/rust/comments/1c64pq8/tantivy_022_has_been_released_performance_and/

Tantivy is a lightweight full-text search engine - MEDevel.com, 11월 7, 2025에 액세스, https://medevel.com/tantivy-search/

tantivy_tokenizer_api - Rust - Docs.rs, 11월 7, 2025에 액세스, https://docs.rs/tantivy-tokenizer-api

tantivy v0.12 released : r/rust - Reddit, 11월 7, 2025에 액세스, https://www.reddit.com/r/rust/comments/f6aig1/tantivy_v012_released/

Developing a fast Indexing and Full text Search Engine with Whoosh: A Pure-Python Library, 11월 7, 2025에 액세스, https://appliedmachinelearning.wordpress.com/2018/07/31/developing-a-fast-indexing-and-full-text-search-engine-with-whoosh-a-pure-python-library/

I finally found a currently-maintained version of Whoosh, a text search library : r/Python, 11월 7, 2025에 액세스, https://www.reddit.com/r/Python/comments/1gm8ovf/i_finally_found_a_currentlymaintained_version_of/

analysis module — Whoosh 2.7.4 documentation - Read the Docs, 11월 7, 2025에 액세스, https://whoosh.readthedocs.io/en/latest/api/analysis.html

About analyzers — Whoosh 2.7.4 documentation, 11월 7, 2025에 액세스, https://whoosh.readthedocs.io/en/latest/analysis.html

Creating custom analyzers using whoosh - Stack Overflow, 11월 7, 2025에 액세스, https://stackoverflow.com/questions/47333814/creating-custom-analyzers-using-whoosh

Whoosh: a fast pure-Python search engine | Hacker News, 11월 7, 2025에 액세스, https://news.ycombinator.com/item?id=478326

Replacing Elasticsearch with Rust and SQLite (2017) - Hacker News, 11월 7, 2025에 액세스, https://news.ycombinator.com/item?id=27175284

[Xapian-discuss] Chinese, Japanese, Korean Tokenizer., 11월 7, 2025에 액세스, https://lists.tartarus.org/pipermail/xapian-discuss/2007-June/003921.html

Writing a tokenizer, where to begin? - Stack Overflow, 11월 7, 2025에 액세스, https://stackoverflow.com/questions/5918512/writing-a-tokenizer-where-to-begin

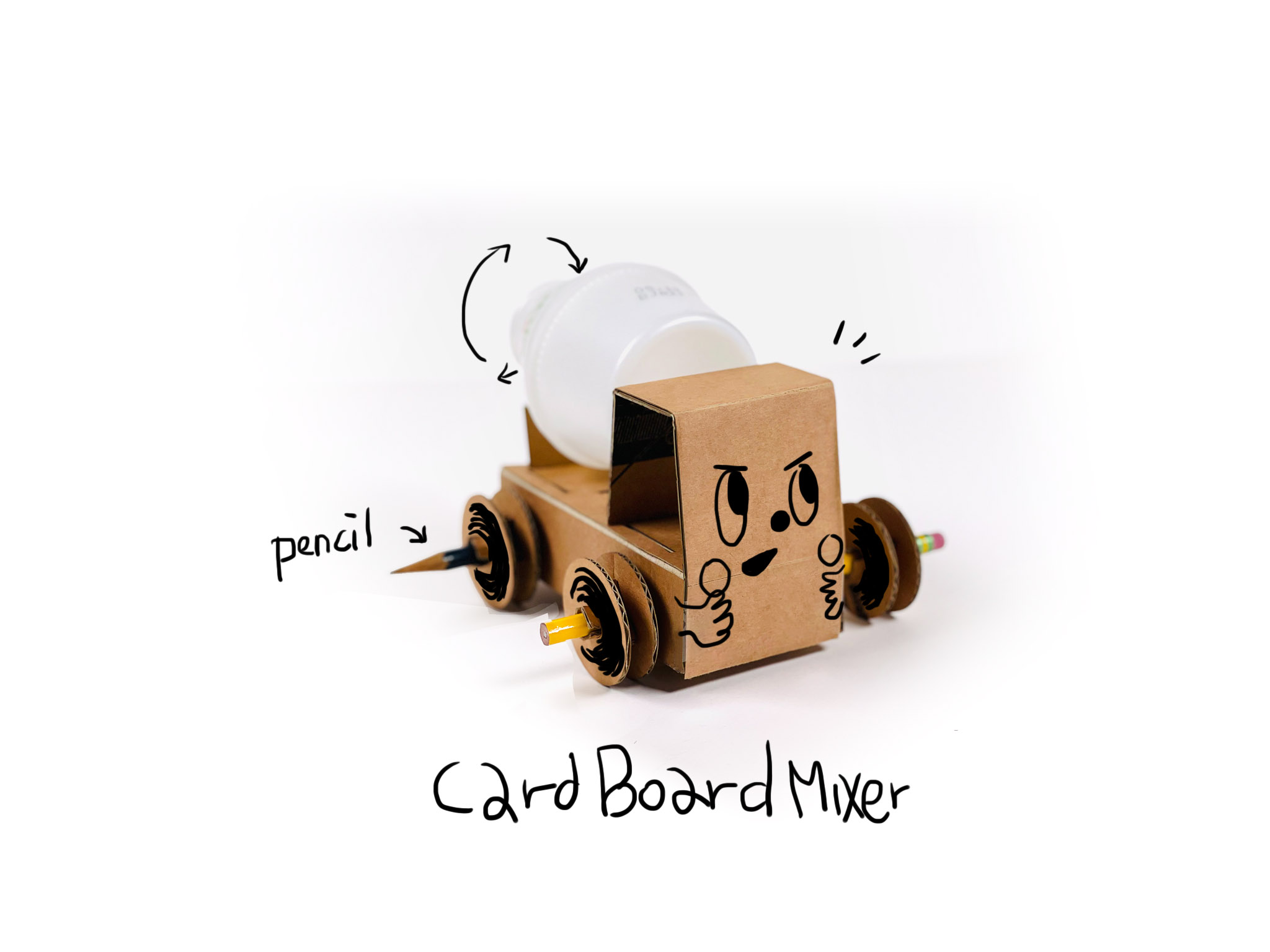

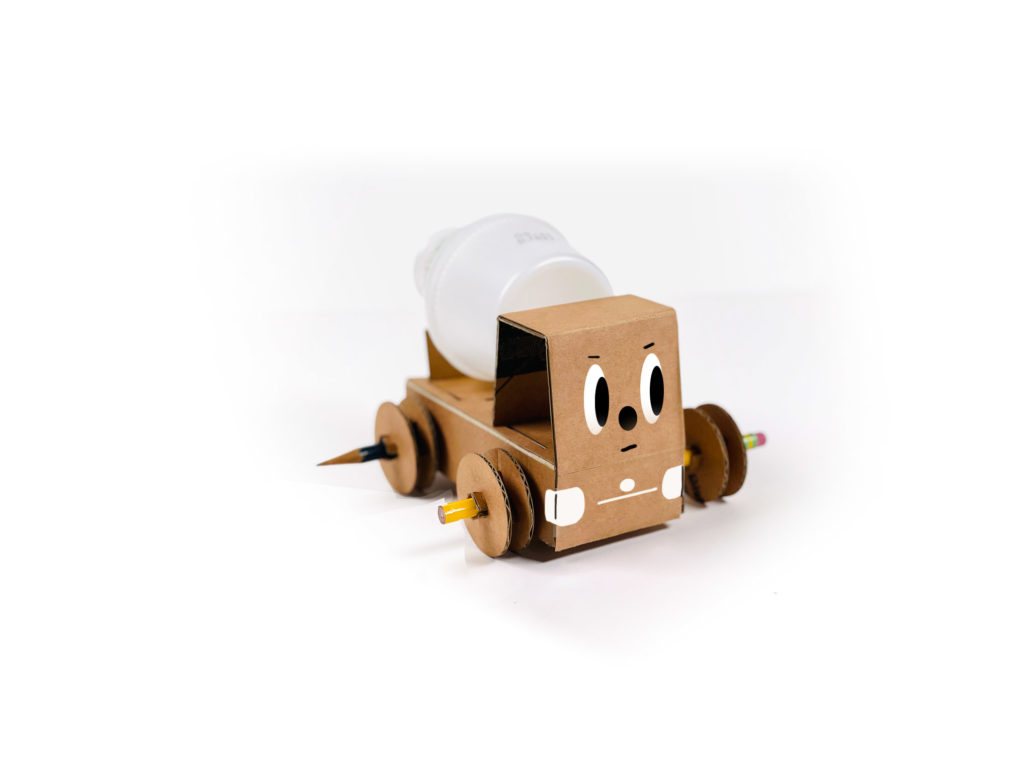

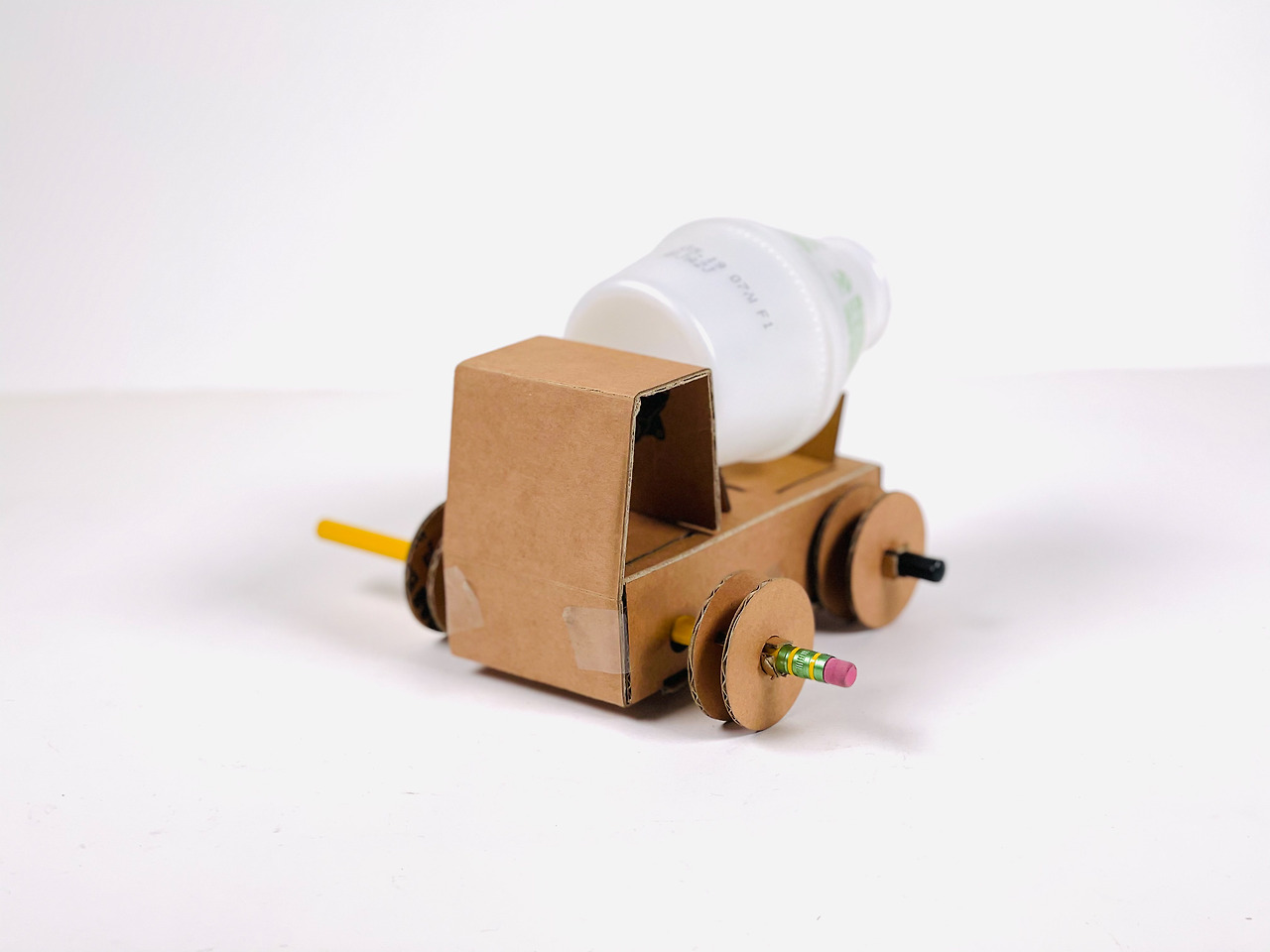

바나나우유 레미콘을 다시 디자인

바나나우유 레미콘을 다시 디자인

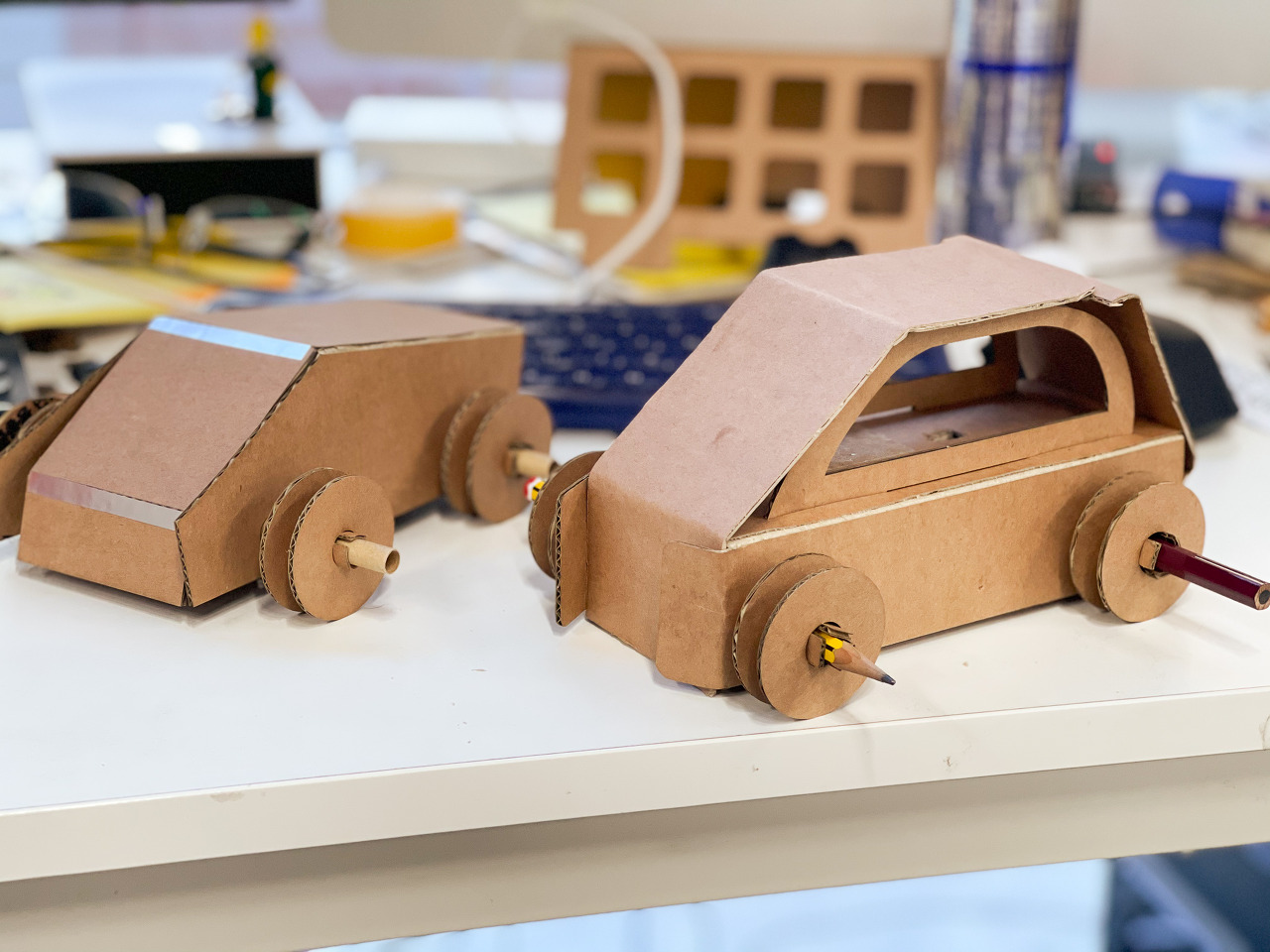

요철을 기반으로 조합할 수 있게 디자인을 바꿀 예정입니다.

요철을 기반으로 조합할 수 있게 디자인을 바꿀 예정입니다.

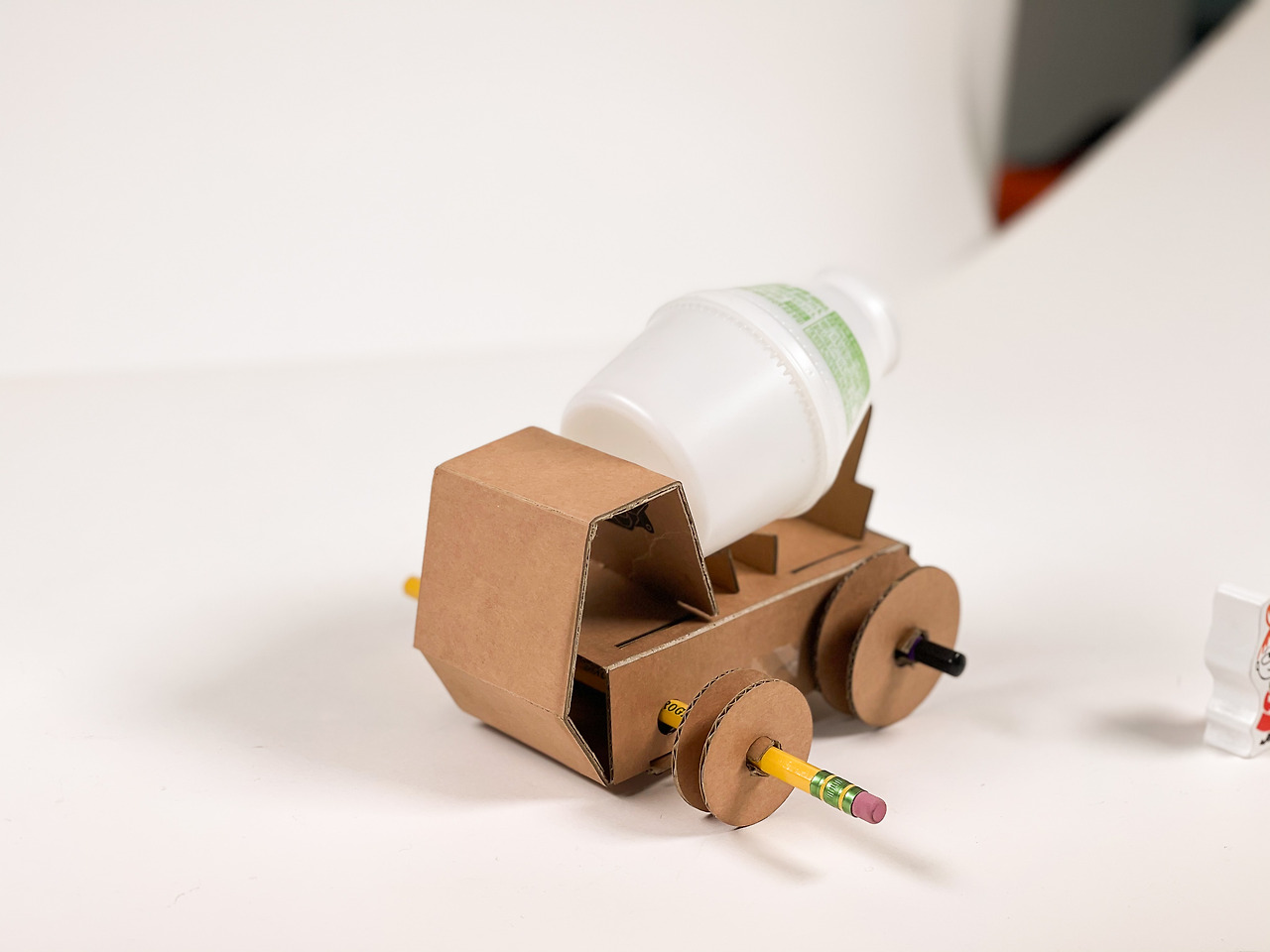

1차 작업 끝

1차 작업 끝 단지형 바나나우유에 조명을 켜면

단지형 바나나우유에 조명을 켜면

Creative Cloud 모든 앱 플랜을 50% 이상 할인가에 이용하세요. 11월 13일 종료.

Creative Cloud 모든 앱 플랜을 50% 이상 할인가에 이용하세요. 11월 13일 종료.